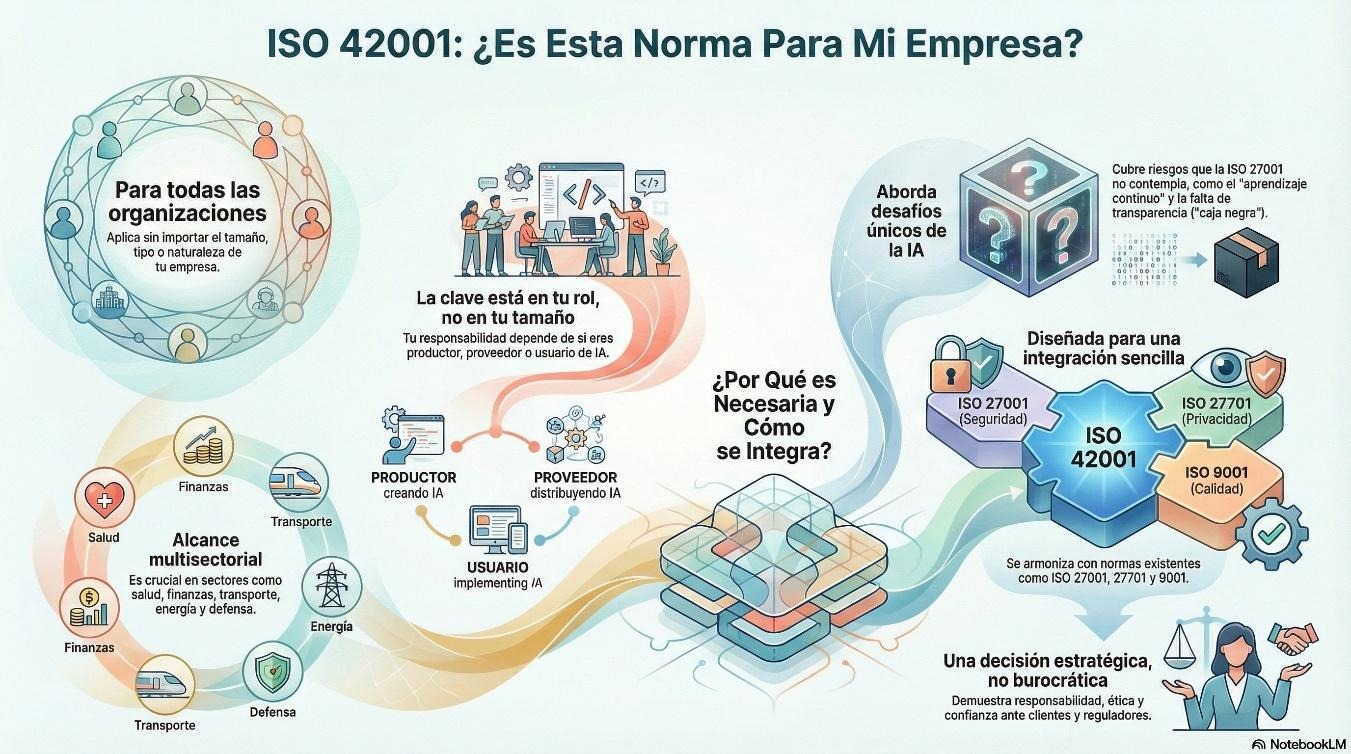

Las normas ISO son estándares que, entre otras cosas, proponen bases para gestionar los aspectos de una organización, y la ISO/IEC 42001: 2023 hace lo propio para el desarrollo y uso de la inteligencia artificial en una empresa. Esta norma llegó con el creciente avance de la tecnología y el auge de la inteligencia artificial (IA), para responder a la inquietud de cómo usar la IA sin que se convierta en un riesgo incontrolable. En cuanto a su aplicabilidad, ¿esta norma es solo para los gigantes tecnológicos de Silicon Valley o sirve para organizaciones que emplean IA en al menos un departamento?

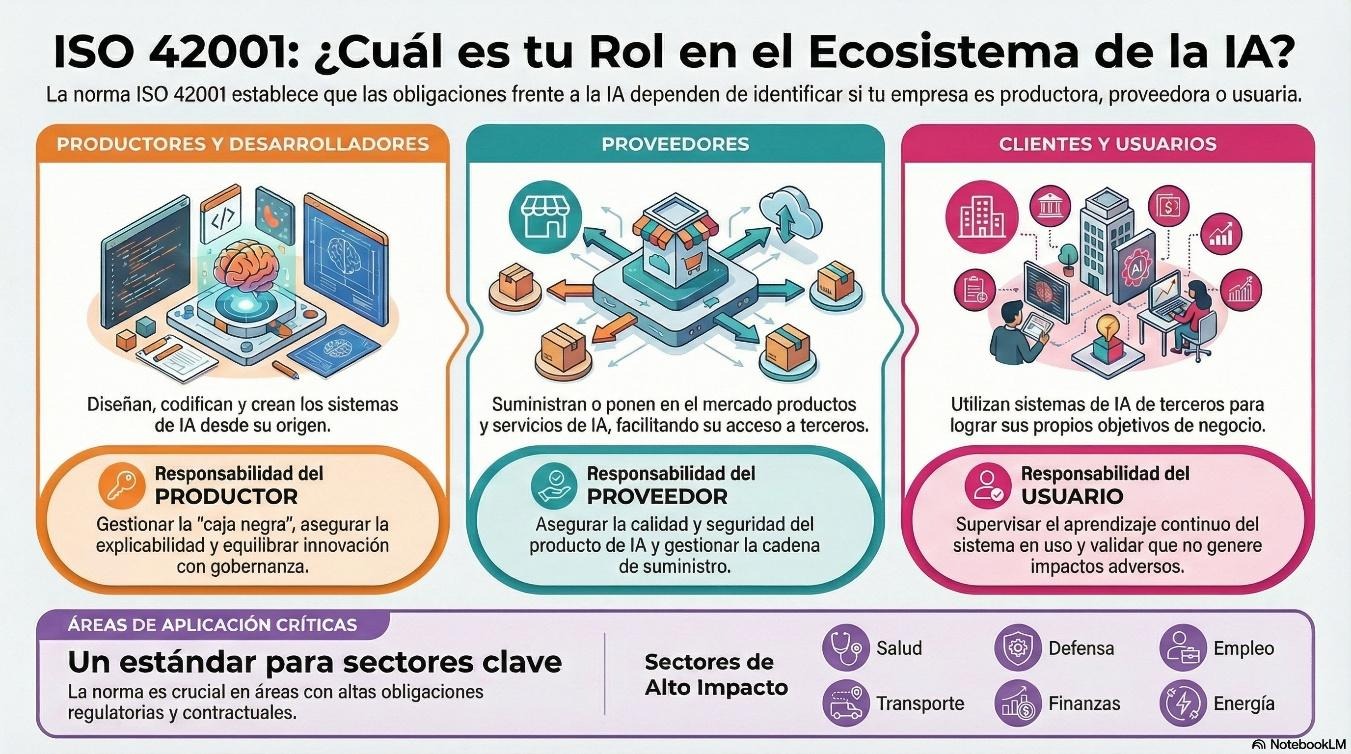

La norma específica que es aplicable a cualquier organización, sin importar su tamaño, tipo o naturaleza, que proporcione o utilice productos o servicios que exploten la IA. De modo tal que no es necesario que la compañía desarrolle software complejo, sino que se encuentre en alguno de estos 3 grupos:

- Productores y desarrolladores: Quienes diseñan y crean la IA.

- Proveedores: Quienes suministran productos o servicios que usan IA (incluyendo plataformas).

- Clientes y usuarios: Organizaciones que utilizan sistemas de IA para sus objetivos.

Los controles que se deben aplicar, el alcance y las responsabilidades dependerán del grupo de pertenencia.

Si está en alguno de estos grupos ¿basta con implementar normas sobre tecnología de la información?

Si ya cuentas con un sistema de gestión orientado a las tecnologías de la información, como el basado en ISO/IEC 27001, puedes pensar que has hecho lo suficiente. Pero lo cierto es que ISO/IEC 42001 aborda aspectos, desafíos y características que son únicos de la IA y que la gestión de tecnología de la información (TI) tradicional no suele cubrir. Mientras que las normas de TI se pueden enfocar en la integridad del sistema, la gestión de IA bajo la ISO/IEC 42001 se centra en la integridad de la decisión. ISO/IEC 42001 atiende aspectos como:

- Aprendizaje continuo: Sistemas que cambian su comportamiento durante el uso. El software tradicional es determinista: si no se cambia el código, siempre hace lo mismo. La IA, en cambio, sufre de degradación. Si los datos del mundo real cambian (por ejemplo, los hábitos de consumo tras una pandemia), el modelo de IA empieza a dar respuestas erróneas, aunque el código esté perfecto. La gestión de TI no está acostumbrada a monitorear la vigencia del conocimiento de un software.

- Falta de transparencia (caja negra): La toma de decisiones automática en formas que a veces no son explicables.

- Gobernanza vs. innovación: La necesidad de equilibrar los mecanismos de control con la capacidad de innovar.

- El sesgo algorítmico y la equidad: Un servidor tradicional no es racista ni clasista; solo procesa datos. Pero un modelo de IA puede heredar prejuicios humanos presentes en los datos de entrenamiento. La gestión de TI clásica se asegura de que el sistema esté disponible, pero la gestión de IA debe asegurar que el sistema sea justo. Esto requiere auditorías de ética y diversidad que no existen en el mantenimiento de servidores normales.

- Alucinación y falta de veracidad: Si Excel arroja que 2+2 es 5, es un error de sistema. Si un modelo de lenguaje responde con total seguridad que una ley no existe aunque no sea cierto, está alucinando. Gestionar esto requiere controles de veracidad y validación de resultados que van mucho más allá de las pruebas de estrés o de carga de la infraestructura tecnológica común.

- La propiedad intelectual de los datos de entrenamiento: En TI lo que preocupa es la licencia del software. En IA, el desafío es saber: ¿de dónde salieron los millones de datos usados para entrenar el modelo? ¿tenemos permiso para usarlos? Esto crea un riesgo legal nuevo y masivo que la gestión de TI estándar, que solo mira instalaciones y parches, no suele supervisar.

Siempre es posible integrar

La norma está diseñada bajo la estructura armonizada para integrarse perfectamente con lo que ya has implementado, sea ISO/IEC 27001, para abordar los objetivos de seguridad de la información de forma sistemática; sea ISO/IEC 27701, determinante cuando los sistemas de IA procesan información de identificación personal; o ISO 9001, para reforzar la confianza del cliente en la calidad de los productos o servicios que incluyen IA. Si piensas que la aplicabilidad de este estándar solo abarca a empresas tecnológicas, te contamos que es muy útil para una gran variedad de sectores que están sujetos a obligaciones o compromisos contractuales, tales como salud, defensa, transporte, finanzas, empleo y energía.

Implementar dependiendo del ángulo

La aplicabilidad de la norma depende de la relación de la organización con la inteligencia artificial, pues determina qué controles específicos deberás aplicar y hasta dónde llega tu responsabilidad legal y ética.

- Productores y desarrolladores: Son quienes diseñan y crean la IA. Si tu organización entrena algoritmos, escribe el código o diseña la arquitectura del modelo, tu responsabilidad es primaria. Aquí el enfoque de la norma suele centrarse en la «caja negra» y la transparencia: te compete gestionar cómo se toman las decisiones automáticas y asegurar que el diseño tenga lo necesario. Es deseable conseguir equilibrar la innovación técnica con los mecanismos de gobernanza.

- Proveedores: Suministran productos o servicios de IA, incluyendo plataformas. No crean el código desde cero, pero lo ponen en el mercado o facilitan su acceso a terceros. Tu rol implica asegurar que lo que entregas cumple con los requisitos de calidad y seguridad, gestionando la cadena de suministro.

- Clientes y usuarios: si tu organización simplemente utiliza sistemas de IA para lograr sus objetivos, la norma también aplica. No necesita ser una empresa de software. Si trabajas en un banco, que usa IA para detectar fraudes, o un hospital, que la emplea para diagnósticos, estamos hablando de un usuario. Tu responsabilidad no es diseñar el algoritmo, sino gestionar su uso: supervisar el aprendizaje continuo (cómo cambia el comportamiento del sistema durante el uso) y validar que el sistema no genere impactos adversos en tu contexto específico.

Evaluación de impacto vs. evaluación de riesgos en IA

Si tu organización decide implementar la norma ISO/IEC 42001:2023 podrías enfrentarte con una dualidad que genera confusión: la exigencia de realizar una evaluación de riesgos y, por separado, una evaluación de impacto. ¿No son lo mismo? En la gestión tradicional de TI se suele ver como un mismo elemento, pero la IA requiere un enfoque distinto. Para entender el estándar, tomemos en cuenta que este opera con dos motores de análisis que, aunque interconectados, tienen objetivos y audiencias muy diferentes:

1. Evaluación de riesgos de IA: la mirada interna

La evaluación de riesgos (cláusula 6.1.2) es el proceso clásico que los gestores de calidad y seguridad conocen bien. Su enfoque principal es el efecto de la incertidumbre sobre los objetivos de la organización. Aquí nos preguntamos: ¿Qué amenazas pueden impedir que nuestra empresa logre sus metas? El enfoque es financiero, operativo, reputacional y legal. Se busca que sea seguro para la organización desplegar el sistema de gestión.

2. Evaluación de impacto del sistema de IA: la mirada externa

La gran novedad de la ISO 42001 es la formalización de la evaluación de impacto (cláusula 6.1.4). Este proceso no se preocupa directamente por la rentabilidad de la empresa, sino por las consecuencias para los individuos y la sociedad. La norma exige este análisis porque la IA presenta desafíos únicos que la gestión de TI no suele cubrir, tales como la falta de transparencia y el aprendizaje continuo, donde los sistemas pueden cambiar su comportamiento y afectar a las personas de formas imprevistas. Esta evaluación busca responder cómo afecta el sistema de gestión a las personas, independientemente de si la empresa gana o pierde dinero.

0 comentarios